In dieser Anleitung zeigen wir euch, wie man eine grafische Oberfläche für Ollama über Docker installieren kann.

Über die Installation von Ollama haben wir bereits einen Artikel geschrieben:

Open WebUI ist ein interaktives Interface, über welches man mit seinen KI-Modellen chatten kann.

Die Installation läuft auch wieder über Docker. Dazu brauchen wir nur diesen einen Code:

sudo docker run -d -p 3000:8080 -e OLLAMA_BASE_URL=http://IP -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:mainDer Port von Ollama ist 11434. Falls ihr Ollama auf eurem gleichen Gerät habt wie Open WebUI, könnt ihr als URL „http://host.docker.internal:11434“ nutzen.

Falls ihr sogar noch eine Nvidia GPU habt, könnt ihr diese auch nutzen; dann wird die KI allgemein noch schneller:

sudo docker run -d -p 3000:8080 --gpus all --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:cudaWenn die Installation erfolgreich war, dann solltet ihr unter IP-Adresse:3000 die Login-Fläche für Open WebUI sehen. Den Port könnt ihr auch beliebig anpassen.

Die erste Person, die sich registriert, wird der Admin sein.

Wenn man sich in einem neuen Gerät anmeldet, werden immer zuerst noch die Release Notes angezeigt.

Jetzt gehen wir rechts oben auf das Profil-Icon und dann auf „Settings“, also in die Einstellungen:

Unter „Connections“ musst du dann überprüfen, ob die richtige URL zu Ollama angegeben ist:

Theoretisch könnte man auch die Ollama-Url über Cloudflare Tunnel frei geben und dann über https:// aufrufen.

Wenn ihr alle URLs richtig eingegeben habt, dann könnt ihr rechts neben dem Base URL – Eingabefeld den Button zum Aktualisieren drücken und wenn die Verbindung erfolgreich hergestellt wurde, sollte das oberhalb den Einstellungen auch angezeigt werden:

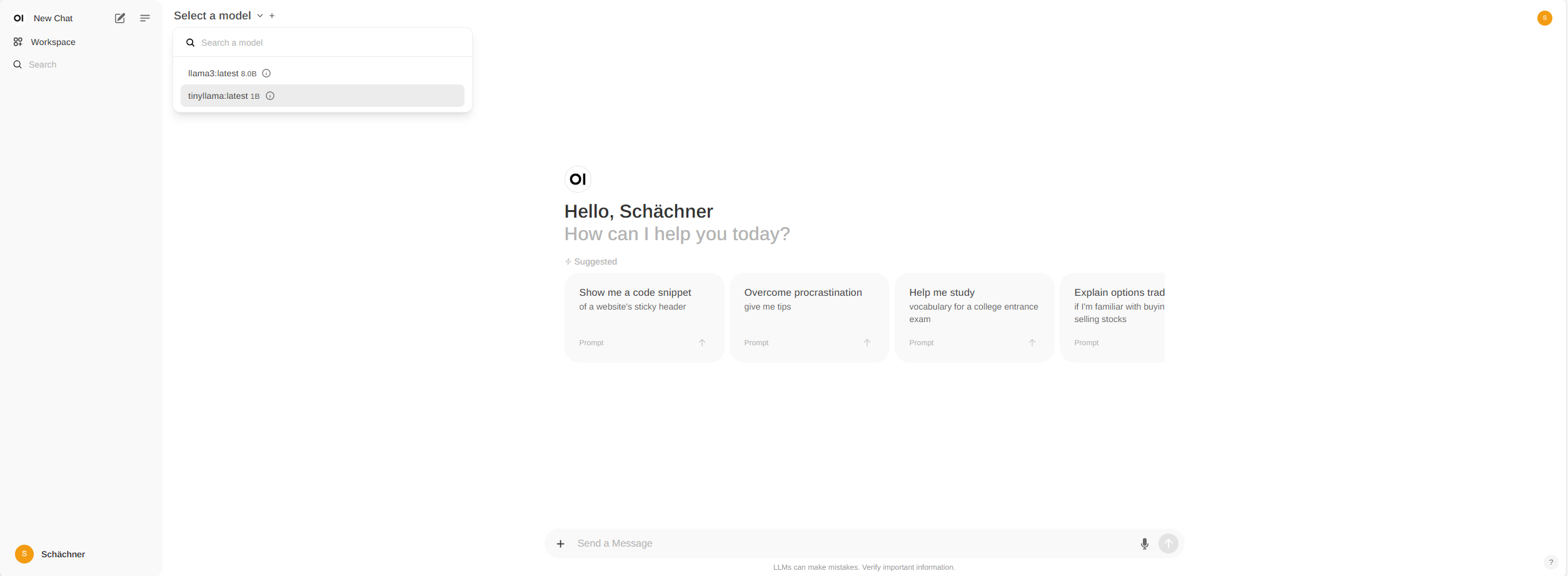

Jetzt können wir oben rechts neben der Seitenleiste auf „Select a Model“ gehen und hier werden alle verfügbaren Modelle, die installiert sind, angezeigt.

Hier musst du nur eins auswählen und dann kannst du dich über das Texteingabefeld unten in der Mitte mit der jeweiligen KI unterhalten.

Theoretisch würde es auch die Möglichkeiten geben, Bilder zu erstellen und erklären zu lassen oder Dokumente hochzuladen und daraus antworten zu generieren bzw. eigene GPT’s erstellen, wie es mit ChatGPT+ möglich ist.

Falls es Fragen zur Installation gibt, könnt ihr diese gerne unten in die Kommentare oder an server@schächner.de schreiben.

Schreiben Sie einen Kommentar